Actas del Congreso Nacional de

Tecnología Aplicada a Ciencias

de la Salud

Actas del Congreso Nacional de Tecnología Aplicada a Ciencias de la Salud Vol. 2, 2019

En los últimos años, los ambientes virtuales inmersivos (IVE) han sido cada vez más utilizados en diversas áreas, principalmente en la educación, entretenimiento, medicina y psicoterapias como herramienta para que el usuario experimente el sentido de presencia en un mundo donde se mezcla lo virtual con lo real. En este sentido, las interfaces cerebro-computadora (ICC) también se han conectado a los IVE’s para manipular objetos virtuales con la modulación de las ondas cerebrales. Por ello, se propone la implementación de un sistema donde se integra la tecnología de los IVEs y las ICC para controlar el robot Nao empleando el paradigma de movimiento imaginado, en el que se promueva el sentido de presencia. De esta manera, se podrán analizar fuera de línea las señales electroencefalográficas (EEG) y conocer más acerca de los procesos cognitivos involucrados.

Palabras clave: Interfaz Cerebro-Computadora, Sentido De Agencia, Ambientes Virtuales Inmersivos

In the last years, the immersive virtual environments (IVE) have been increasingly used in different áreas, mainly in education, entertainment, medicine and in psychotherapy as a tool to experience a sense of presence in a world where virtual and real can be mixed together. In this sense, brain-computer interfaces (BCI) have also been connected to virtual worlds to explore or control virtual objects with the modulation of brainwaves. Therefore, it is proposed an implementation of a system integrating IVE’s and BCI’s to control Nao robot with the motor imagery (MI) paradigm. In this way, electroencephalographic (EEG) signals can be analyzed offline to learn more about the congnitive processes involved in sense of agency.

Keywords: Brain-Computer Interface, Sense Of Agency, Immersive Virtual Environments

Los ambientes virtuales inmersivos son cada vez más utilizados en diversas áreas, tales como la medicina, neurorrehabilitación, educación y entretenimiento. Con el tiempo, las interfases cerebro-computadora también han integrado esta tecnología utilizando mayormente los paradigmas P300 y potenciales visuales evocados de estado estable (SSVEP).1–3La ventaja de estos dos paradigmas es que no se requiere de largo tiempo de entrenamiento para que el usuario pueda ser capaz de utilizarlo. Sin embargo, se requiere de un estímulo externo para poder modular la señal de EEG, lo que no permite enviar las señales de control a voluntad y se limita la experiencia del sentido de agencia en el usuario. Por otra parte, en 4, 5 utilizan el paradigma de movimiento imaginado para promover una mayor motivación y compromiso al controlar aplicaciones virtuales. De esta manera, en este trabajo se presenta la integración de un IVE junto con una ICC utilizando el paradigma de movimiento imaginado cumpliendo con los requisitos necesarios para alcanzar a promover el sentido de agencia en el usuario, la cual nos permitirá obtener las señales EEG durante estos experimentos y proceder a su análisis para conocer más acerca de las características de los procesos cognitivos involucrados.

El objetivo de este sistema inmersivo es que a través de un visor pasivo sujeto a la cabeza generar en el usuario un sentido de presencia durante el control del robot Nao por medio de la modulación de sus ondas cerebrales con el movimiento imaginado. Para cumplir con dicho objetivo, el sistema debe cumplir con las siguientes especificaciones:

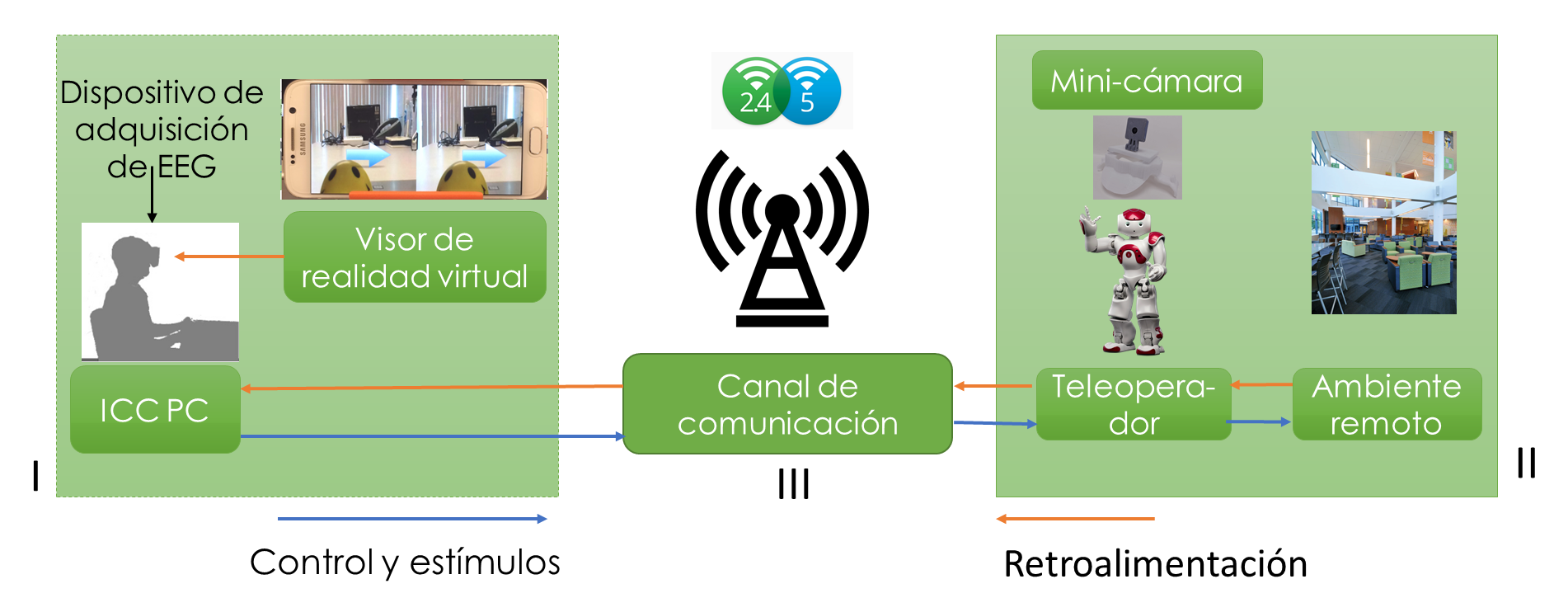

La implementación se puede dividir en dos partes. La primera contiene los componentes del sistema de la ICC considerando la retroalimentación de video estereoscópica del ambiente remoto. La segunda parte es el software implementado con el usuario de la ICC, el sistema para el canal de comunicación y el sistema implementado en el ambiente remoto. La configuración general se presenta en la Figura 1.

Figura 1 Arquitectura general de la implementación del sistema inmersivo de telepresencia

El hardware del sistema inmersivo de telepresencia se divide en 3 módulos. El módulo 1 es donde se encuentra el usuario de la ICC, el cual consiste en una computadora de escritorio (Intel Core i3, 8 GB de RAM), y para la adquisición de las señales de EEG se emplea el sistema inalámbrico MOBITA de 32 canales. Estos son conectados por medio de la red de 2.4 GHz. Se utiliza un celular Samsung S6 (Procesador Exynos 7420 2.1 GHz, 3 GB de RAM y GPU Mali-T760MP8) como el dispositivo colocado en el visor sujeto a la cabeza (HMD). Cabe mencionar que este celular es lo suficientemente poderoso como para tener un retraso imperceptible en la transmisión de video y la aplicación web. En el módulo II, en el lugar donde se encuentra el robot Nao, el robot tiene en su cabeza un casco con una mini-cámara Arducam de 5 MP y resolución de video de 1080p, como se puede observar en la Figura 2. La mini-cámara se conecta a una Raspberry Pi 3 (Rpi) por medio del puerto CSI.

Figura 2. Robot Nao con la mini-cámara y la RPi en su espalda

Por otra parte, para aprovechar las características de la banda de 5 GHz, se utilizó un adaptador de red inalámbrico de doble banda AC600 conectado a la RPi para alcanzar más altas tasas de transferencia durante la transmisión de video. Finalmente, en el módulo III se utiliza un ruteador de doble banda ASUS AC1200, y un servidor sobre la RPi. El resumen de la arquitectura de hardware se encuentra en la Figura 3.

Figura 3. Arquitectura de hardware del sistema inmersivo de ICC

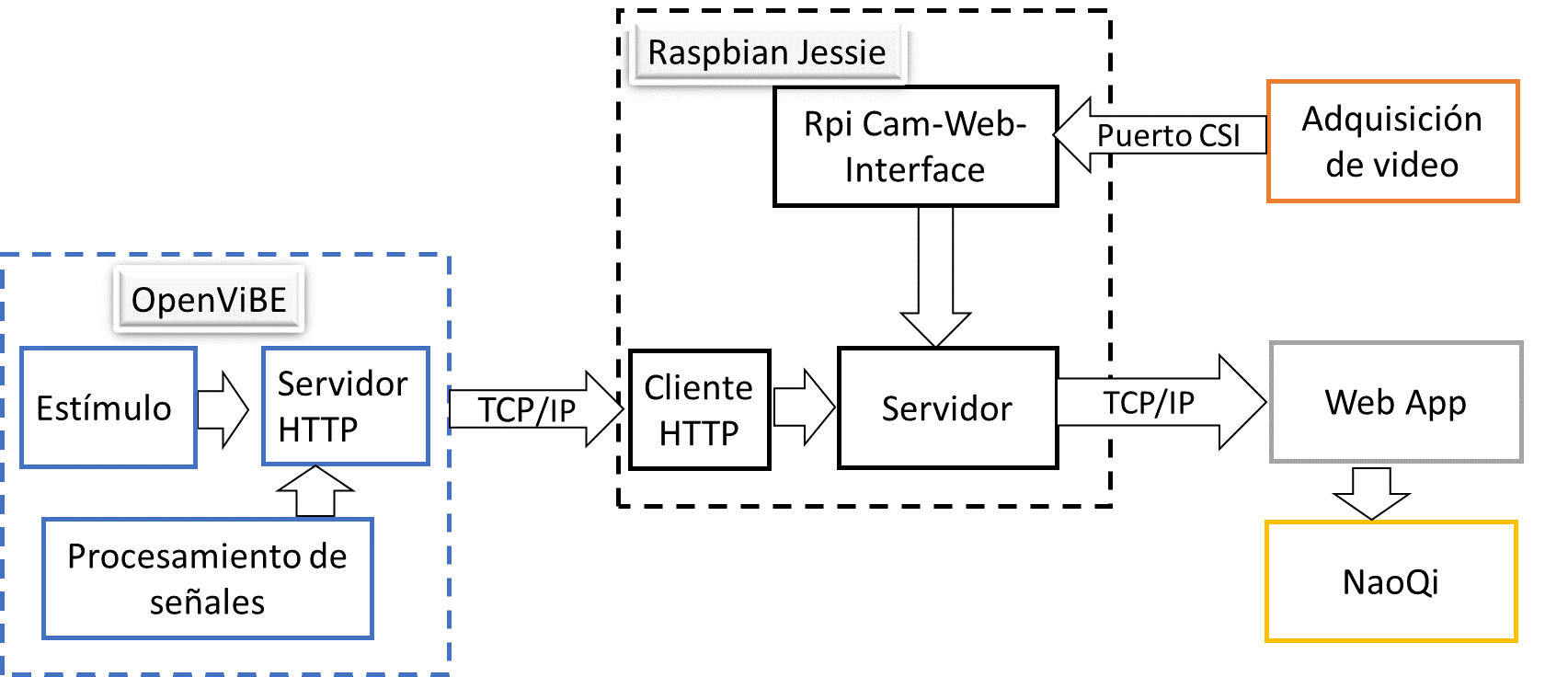

La arquitectura de software se presenta en la Figura 4 Arquitectura de software el sistema utilizado donde se encuentra el usuario de la ICC es una computadora de escritorio con Microsoft Windows 7 de 64 bits el cual ejecuta Python 2.7 y OpenviBE6. En el escenario de OpenViBE se utiliza el módulo de Python para mandar las señales de control hacia la RPi y son reenviadas hacia el robot Nao para su control por medio de TCP/IP. Así mismo, los estímulos generados por el módulo de estímulos LUA son enviados por medio de un servidor HTTP escrito en Python. Los estímulos son recibidos por medio de un cliente HTTP que se encuentra en la RPi y reenviados al servidor principal.

Figura 4. Arquitectura de software del sistema inmersivo de ICC

En el lugar del teleoperador, la RPi usa Raspbian Jessie versión 4.9. Se implementó la interfaz RPi Cam-Web-Interface 7 para tener disponible la transmisión de video desde la mini-cámara. Para cumplir con el requisito número 4 era necesario transmitir de dos cámaras alineadas horizontalmente y con un espacio entre ellas, sin embargo, como restricción de hardware de la RPi solo se tiene un puerto CSI, además que la transmisión de dos cámaras ocuparía más ancho de banda ralentizando la velocidad de transmisión. Por ello, la solución está basada en el Pi Viewer demo de 8, el cual transforma lo que ve la mini-cámara en una transmisión estereoscópica usando JavaScript. Se implementó con modificaciones para juntar la imagen de la cámara con las imágenes de los estímulos de OpenViBE en una aplicación web. El servidor principal se ejecuta en la RPI escrito en Node.js. Este servidor permite la integración de la imagen de la cámara y los estímulos en la aplicación web como se observa en la Figura 5.

Figura 5. Visualización de la imagen estereoscópica de la mini-cámara junto con los estímulos

De esta manera, se registraron 32 canales de EEG los cuales se encuentran localizados de acuerdo con el sistema internacional 10-20 tomando como tierra el electrodo en AFz a una frecuencia de muestreo de 1000 Hertz. La impedancia de los electrodos se mantuvo por debajo de los 5 KΩ.

Se realizó el registro con un sujeto de prueba durante dos sesiones. En la primera sesión se mostraron estímulos en un monitor situado frente a él de acuerdo con el protocolo de Graz 9 con la finalidad de obtener las características del movimiento imaginado al abrir y cerrar la mano derecha y en reposo. La sesión se dividió en 5 repeticiones de 40 estímulos, con un tiempo de descanso de 5 minutos entre cada repetición. En la segunda sesión, el sujeto usó el HMD permitiendo que éste viera el mundo a través de la perspectiva del robot Nao. La sesión consistió en 5 repeticiones de 20 estímulos, 10 de movimiento imaginado y 10 en reposo de forma aleatoria. Se utilizó el clasificador diseñado con las características de la primera sesión para mandar la señal de control al robot Nao diferenciando entre reposo y movimiento imaginado. Cuando se clasifica el movimiento imaginado, el robot Nao sube su mano a la altura de los ojos, abre y cierra su mano, y la baja; cuando se clasifica el reposo el robot Nao permanece quieto.

En la figura 6 se presenta al sujeto de prueba durante el experimento usando el equipo de electroencefalografía y el HMD pasivo con el celular dentro de este. El sujeto no mencionó haber presentado incomodidad al usar el HMD, ni sensación de mareo. Por el contrario, expresó haber disfrutado del experimento en la segunda sesión donde usó el HMD que en la primera sesión viendo únicamente el monitor. Se consiguió un 80% de eficiencia en el control del robot.

Figura 6. Uso del equipo de EEG y HMD durante el experimento

Por otra parte, se alcanzó el nivel de inmersión deseado al cumplir con los requerimientos mencionados en la sección 2. El retraso promedio obtenido fue de 174 ms, tan solo un 14% mayor de lo establecido en la configuración de red de telepresencia de Cisco. 10

El trabajo presentó la descripción de la implementación, integración y evaluación del hardware y software empleados para el procesamiento de señales EEG con un sistema de telepresencia con el que se controla el robot Nao por medio del paradigma de movimiento imaginado. Los resultados preliminares confirman la habilidad del sistema para promover en el usuario el sentido de agencia obteniendo un retraso de las señales muy cercano al solicitado por Cisco. El sujeto es capaz de controlar al robot Nao con la modulación de las señales EEG teniendo una perspectiva de primera persona como retroalimentación.

De esta manera, se presenta la implementación del sistema de telepresencia que podrá ser utilizado en un futuro para el análisis de las señales EEG en las diferentes etapas del control gracias a la sincronización entre sus módulos, para obtener más información sobre los procesos cognitivos en dichos ambientes. Como trabajo futuro, se pueden seguir integrando otro tipo de sensores y actuadores para obtener un sistema completamente inmersivo y también mejorar el clasificador para poder tener acceso a más señales de control.